Warum Standards für KI-Systeme entwickelt werden – und wie

Aktuell werden (inter-)nationale Standards und Normen für KI-Systeme definiert, mit denen die so genannte „Konformitätsvermutung“ erfüllt werden kann. Wir haben für metafinanz die Standardisierung DIN SPEC 92001-3 „Künstliche Intelligenz – Life Cycle Prozesse und Qualitätsanforderungen – Teil 3: Erklärbarkeit“ mitgestalten dürfen und berichten über den aktuellen Stand bezüglich der Normung von KI und ihre Vorteile.

Der AI Act der Europäischen Union (EU) – auch als „Gesetz über Künstliche Intelligenz“ oder „KI-Verordnung“ geläufig – zielt darauf ab, einen rechtlichen Rahmen für die Entwicklung und den Einsatz von Künstlicher Intelligenz (KI) in der EU zu schaffen. Die Verordnung teilt dabei KI-Systeme in vier Risikokategorien ein: minimales Risiko, mittleres Risiko mit Anforderungen an Transparenz, Hochrisiko-KI-Systeme sowie verbotene Praktiken mit unvertretbarem Risiko. Dass die Verordnung ein bahnbrechendes, aber auch brisantes Regulierungsinstrument ist, haben wir an dieser Stelle aufgezeigt.

AI Act, Normen, Zertifizierungen

Im Zusammenhang mit der KI-Verordnung sind die darin formulierten Anforderungen an Hochrisiko-KI-Systeme von großer Bedeutung, also an ihre Sicherheit, Robustheit, Transparenz, Erklärbarkeit sowie weitere Aspekte. Hersteller können die Konformität mit dem AI Act auf verschiedene Weisen bestätigen. Bei der internen Überprüfung muss das Unternehmen sicherstellen, dass ihr KI-Produkt die in der Verordnung festgelegten Kriterien erfüllt. Ähnlich verhält es sich bei der externen Prüfung durch eine Zertifizierungsstelle. Dieser Prozess umfasst eine unabhängige Bewertung und Bestätigung der Konformität. In beiden Fällen ist das Verfahren in der Regel zeitaufwändig und kostenintensiv, wie wir bereits in diesem Artikel dargestellt haben.

Normen: Einfacherer Konformitätsnachweis

Durch die Einhaltung anerkannter Normen kann die Konformität jedoch deutlich schneller, effizienter, aber auch nachhaltiger nachgewiesen werden. Normen bieten einen klar definierten und weitgehend standardisierten Rahmen. Sie sind technische Spezifikationen oder Leitlinien, die von anerkannten Normungsinstitutionen entwickelt werden, um sicherzustellen, dass Produkte, Dienstleistungen und Systeme sicher, effizient und austauschbar sind. Wird ein Produkt nach einer anerkannten Norm hergestellt, so wird grundsätzlich vermutet, dass es den Anforderungen der entsprechenden EU-Richtlinie entspricht. Dies erleichtert und beschleunigt den Konformitätsprozess erheblich.

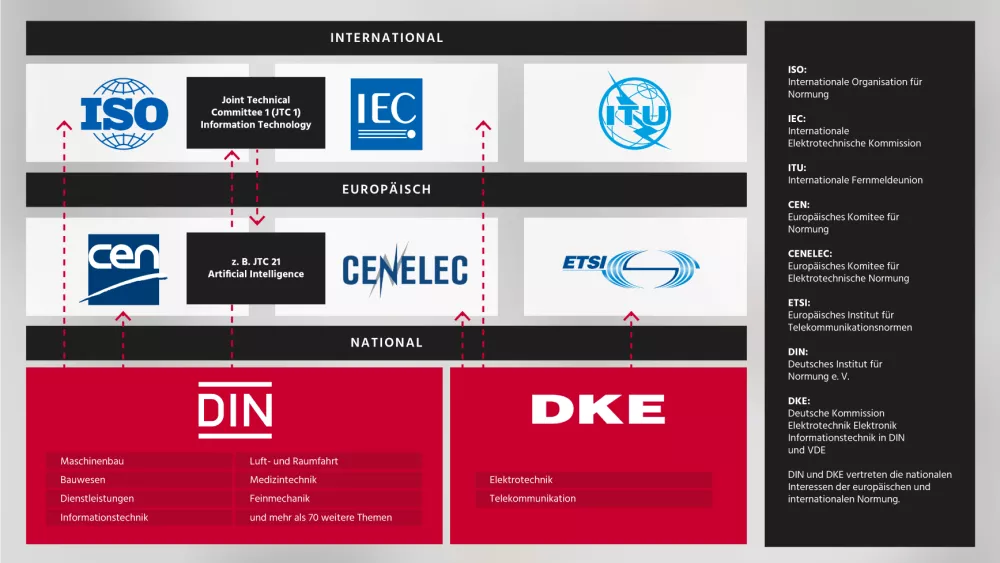

(Quelle: Eigene Abbildung / metafinanz in Anlehnung an DIN)

Aktueller Stand und Entwicklung von KI-Normung

Im Falle des AI Acts werden in Deutschland entsprechende Normen und Standards auf nationaler Ebene durch das Deutsche Institut für Normung (DIN) e.V. koordiniert. Die Konzipierung und Organisation wird seit Mai 2021 durch die Koordinierungsgruppe KI-Normung und -Konformität (kurz KI-Koordinierungsgruppe) durchgeführt, bestehend aus führenden Vertretungen der Politik, Forschung, Gesellschaft und Ethik sowie Industrie und Wirtschaft. Zusammen mit der DKE, der „Deutschen Kommission Elektrotechnik Elektronik Informationstechnik“, wurde in der „Deutschen Normungsroadmap KI Ausgabe 2“ Ende 2022 einerseits der aktuelle Zwischenstand bei der Erarbeitung von Normen und Standards und andererseits der weitere Bedarf an diesen identifiziert.

Unsere Mitwirkung in der KI-Normungsroadmap

Ein Beispiel für einen solchen Standard ist die Serie DIN SPEC 92001, „Künstliche Intelligenz – Life Cycle Prozesse und Qualitätsanforderungen“. Sie ist in drei Teile gegliedert: Teil 1 (DIN SPEC 92001-1) befasst sich mit der Einrichtung eines „Qualitätsmetamodells“ für die Entwicklung von KI-Systemen mit den Kernaspekten Leistung & Funktionalität, Robustheit und Verständlichkeit. Teil 2 (DIN SPEC 92001-2) beschäftigt sich mit notwendigen Voraussetzungen an Systeme, die ein besonderes Maß an Robustheit garantieren sollen. Der dritte Teil der DIN SPEC 92001 dient als domänenunabhängiger Leitfaden zur Erklärbarkeit über alle Phasen des Lebenszyklus eines KI-Systems hinweg.

KI-Opacity vs. KI-Transparenz

Wir beide haben als so genannte Konsortialmitglieder an der Erarbeitung der DIN SPEC 92001-3 zur Erklärbarkeit mitgewirkt. Diese SPEC definiert den Begriff „Opacity“ (Undurchsichtigkeit), beschreibt die Ursachen und Auswirkungen der Undurchsichtigkeit in modernen KI-Systemen und zeigt auf, wie Erklärungen eingesetzt werden können und sollten, um diese Auswirkungen für verschiedene Interessengruppen in den verschiedenen Phasen des Lebenszyklus eines KI-Systems abzumildern.

Die beschriebenen Qualitätskriterien zielen darauf ab, für alle Arten von KI-Systemen mit unterschiedlichen Graden an Undurchsichtigkeit und in allen Einsatzbereichen anwendbar zu sein. So erleichtern diese Qualitätskriterien ein besseres Verständnis und eine effektivere Nutzung von erklärbarer Künstlicher Intelligenz (XAI), indem sie Organisationen ermöglichen, Prinzipien von Vertrauen und Transparenz in ihre KI-basierten Anwendungen einzubetten. Sie liefern außerdem die konzeptionelle und verfahrenstechnische Grundlage, um spezifische Anforderungen an Erklärbarkeit und technisch korrekten Betrieb zu formulieren.

Fazit: KI erfordert mehrere Perspektiven

Die Komplexität und das enorme Potenzial von KI bedeuten, dass die Entwicklung von Normen und Standards für diesen Bereich nicht isoliert betrachtet werden kann. Im Gegenteil: Sie erfordert die Einbindung einer Vielzahl von Experten, die unterschiedliche Perspektiven und Fachwissen einbringen können. Diese Herausforderung sowie die konstruktive Mitgestaltung hat uns motiviert, an der SPEC 92001-3 als Konsortialmitglieder teilzunehmen.

Die Zusammenarbeit mit Experten aus verschiedenen Fachrichtungen und Branchen war sehr bereichernd und hat uns großen Spaß gemacht. Im Rahmen der gemeinsamen Arbeit durften wir verschiedene Blickwinkel und Erfahrungen austauschen und diskutieren. Zusammenfassend stehen wir hinter dieser Standardisierung und sind von einem konkreten und positiven Mehrwert für die Entwicklung zukünftiger KI-Systeme überzeugt.

Quelle Titelbild: AdobeStock/pinkeyes